Revisión a un año de la entrada en vigor del Reglamento de IA (RIA).

El pasado 1 de agosto se cumplió un año de la entrada en vigor del nuevo Reglamento 2024/1689 del Parlamento Europeo y del Consejo, 13 de junio de 2024, por el que se establecen normas armonizadas en materia de inteligencia artificial, también conocido como Reglamento de IA (RIA), de aplicación directa para España como Estado Miembro de la Unión Europea.

Su publicación, enmarcada en el proceso de desarrollo de lo que ya se denomina “derecho europeo de la ciencia y la tecnología”, responde a un intento de la Unión Europea de encontrar un equilibrio entre (1) la tutela y protección de los derechos fundamentales y (2) la libertad en la investigación y el desarrollo tecnológico.

Sin ánimo de realizar un análisis exhaustivo de todo el contenido normativo relativo y aplicable a los sistemas de IA que, en múltiples ocasiones, responde a necesidades específicas de sectores concretos (como pueden ser la ciberseguridad, el copyright, la minería de datos, la Administración estatal y autonómica, etc.), en el presente artículo trataremos de dar respuesta a cuál es, con carácter general, el marco normativo de regulación de la Inteligencia Artificial en la actualidad.

1.- Reglamento de Inteligencia Artificial (RIA)

Respecto a su ámbito de aplicación, el Reglamento resultará aplicable a una serie de “operadores” (personas físicas o jurídicas, autoridades públicas, órganos u organismos obligados bajo el RIA) recogidos en los artículos 2 y 3 del RIA, entre los que destacaríamos, a efectos de este artículo y en la medida en la que son los operadores con mayor presencia en nuestro mercado, los siguientes:

- Proveedores: Todo sujeto, establecido o ubicado en la Unión o en un tercer país, que desarrolle un sistema de IA o modelo de IA de uso general (también denominados GAIP) para introducirlo en el mercado de la Unión Europea (UE) bajo su propio nombre o marca comercial, previo pago o gratuitamente, o cuyos resultados de salida generados por el sistema de IA se utilicen en la UE. La empresa OpenAI, como distribuidora del sistema de IA “ChatGPT” en Europa, entra dentro de la categoría de proveedor conforme al RIA.

- Responsables del despliegue: Todo sujeto, establecido o ubicado en la UE, que utilice un sistema de IA, bajo su propia autoridad y/o dentro de su ámbito profesional. Al respecto, toda empresa residente en la Unión que haga uso de cualquier sistema de IA en el desarrollo de cualquiera de las fases de su actividad empresarial será responsable del despliegue de dicho sistema, debiendo asumir una serie de obligaciones en términos de transparencia y control.

- Representantes autorizados: Toda persona física o jurídica ubicada o establecida en la UE que haya recibido y aceptado el mandato por escrito de un proveedor ubicado fuera de la UE para cumplir con las obligaciones y procedimientos del RIA en su nombre.

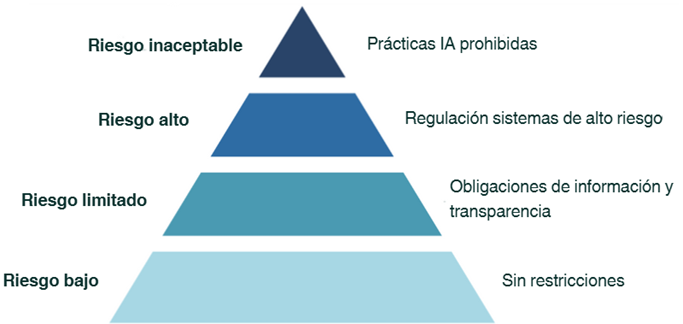

Las obligaciones que los distintos operadores deben asumir en virtud del Reglamento se establecen en función del nivel de riesgo asociado al sistema de IA[1] que utilicen, entendido como una combinación entre la probabilidad de causación de un perjuicio y la gravedad del mismo y que se resume en la siguiente ilustración:

Entre los sistemas de IA de Alto Riesgo destacamos aquellos que son aplicados en el ámbito de la biometría (identificación biométrica remota o reconocimiento de emociones), infraestructuras críticas (tráfico rodado, agua, gas, calefacción o electricidad), educación (determinar el acceso a centros educativos o evaluar el nivel de aprendizaje), empleo y gestión de trabajadores (contratación, selección de personas y asistencia en la toma de decisiones de RRHH), así como aquellos cuyo uso esté orientado a garantizar el cumplimiento del Derecho (evaluación de peligrosidad criminal y asistencia en la fase de instrucción o el proceso de enjuiciamiento de delitos, entre otros) .

Respecto a las obligaciones de los sistemas de IA de riesgo limitado, merece una especial mención el artículo 50 del Reglamento, exigible desde agosto de 2026, que impondrá a proveedores y responsables del despliegue de sistemas de IA destinados a interactuar directamente con personas físicas (usuarios) la obligación de informar expresamente a los usuarios de que (i) están interactuando con un sistema de IA, -por ejemplo, los servicios de atención al cliente o asistencia postventa telemática-, o, en su caso, (ii) de que el contenido a consumir ha sido generado artificialmente o con la asistencia de un sistema de IA, salvo que haya sido sometido a un proceso de revisión o edición humano y cuando una persona física o jurídica tenga la responsabilidad editorial del contenido creado.

Existen, a su vez, ciertas excepciones a la aplicación del Reglamento atendiendo, entre otras, a la materia (seguridad nacional y defensa), el ámbito de aplicación (investigación, desarrollo, uso particular por personas físicas) o el tipo de sistema de IA (sistemas de IA divulgados con arreglo a licencias libres y de código abierto).

2.- Normativa de protección de datos (RGPD y LOPD, entre otras)

Los sistemas de IA, como cualquier otra tecnología, pueden suponer un riesgo para la privacidad de los datos si no se hace un uso responsable de ellos. Por ello, las obligaciones del Reglamento de IA deben aplicarse de forma armonizada junto con la normativa comunitaria (Reglamento Europeo de Protección de Datos) y nacional (Ley Orgánica Española de Protección de Datos de Carácter Personal y Garantía de los Derechos Digitales) relativa a la protección de datos personales.

¿Cuáles son las consecuencias de esta aplicación armonizada? Principalmente, que todo operador que desarrolle o haga uso de IA generativa[2] en su actividad profesional deberá tener en cuenta cuáles son sus obligaciones en materia de protección de datos, de conformidad con la ley. Ello implica que cualquier empresa que haga uso de modelos de IA de uso general (ChatGPT-5, Copilot o Azure OpenAI, entre otros) como una herramienta de apoyo y asistencia en el desarrollo de su actividad empresarial deberá valorar los posibles riesgos de exposición de datos personales a la IA y cumplir con obligaciones legales como la transparencia y defensa de la confidencialidad en el tratamiento de dichos datos.

Al respecto, la asunción como “práctica común” en el seno de las empresas del uso de datos personales para entrenar sistemas o modelos de IA[3] supone un claro incumplimiento del deber de aplicación imperativa de la normativa de protección de datos personales, especialmente cuando dicho uso tiene lugar (i) sin consentimiento expreso de la persona afectada o (ii) mediante su reutilización con fines distintos a los originalmente previstos (cuando las expectativas de la persona que lo proporcionó eran, por defecto, diferentes).

3.- Próximamente: Anteproyecto de Ley para El Buen Uso y la Gobernanza de la Inteligencia Artificial.

Dando cumplimiento al mandato impuesto por el regulador europeo, el pasado 11 de marzo de 2025 el Consejo de Ministros aprobó el Anteproyecto de Ley para El Buen Uso y la Gobernanza de la Inteligencia Artificial en el que, entre otras cuestiones:

(i) Se da respuesta a la efectiva designación de las Autoridades de vigilancia del mercado a efectos del cumplimento del RIA a través de un reparto competencial en el que surge, como novedad, la Agencia Española de Supervisión de Inteligencia Artificial (AESIA) como encargada de garantizar el uso ético y seguro de la IA, y

(ii) Se prevé un régimen sancionador aplicable que contempla sanciones de hasta 15 millones de euros o entre el 2%-3 % del volumen de negocio anual mundial, por infracciones graves como la omisión del etiquetado obligatorio en contenidos generados por IA. En el caso de infracciones muy graves, como el uso de sistemas de IA prohibidos o el uso indebido de sistemas de identificación biométrica remota, las sanciones pueden alcanzar los 35 millones de euros o entre el 2%-7 % del volumen de negocio anual mundial, todo ello conforme al artículo 99 del RIA.

Si bien tendremos que esperar hasta su aprobación para poder conocer de la aplicación de este régimen sancionador a nivel nacional, en España ya hemos tenido los primeros pronunciamientos judiciales relativos al uso indebido de estos sistemas de IA, como es el caso de la Sentencia del Tribunal Superior de Justicia de Pamplona núm. 38/2024, de 4 de septiembre de 2024, en el que se resolvió en pieza separada sobre la posible sanción pecuniaria a un Letrado por el uso indebido del sistema de IA ChatGPT en sus escritos procesales[4] o el Acuerdo núm. 90/2024, por el que la Sala 1ª del Tribunal Constitucional acordó por unanimidad sancionar a un abogado por la falta del debido respeto al tribunal al incluir reiteradas citas de doctrina inventada por la IA.

En el ámbito internacional, las noticias se han hecho eco estas últimas semanas de los errores contenidos en un informe por valor de 440.000 $ elaborado por una conocida firma de auditoría para el Departamento de Empleo y Relaciones Laborales (DEWR) del Gobierno australiano a raíz de las alucinaciones del sistema de IA empleado por la firma, con las consecuencias económicas inherentes a un error de este tipo y el coste reputacional asociado.

4.- Conclusión

El contexto legislativo actual evidencia un cambio en el enfoque y gestión del desarrollo y uso profesional de los sistemas de IA que ha dotado a los Estados no sólo de nuevos instrumentos de supervisión y control, como la citada AESIA, sino también de un régimen sancionador sólido y progresivo, alineado con la gravedad de las posibles infracciones en materia de IA y cuyos primeros supuestos de aplicación ya podemos observar.

En este sentido, y si bien se prevé que el Reglamento de IA entre en vigor de forma escalonada, sería recomendable que las empresas se anticipen a estos requerimientos y dediquen tiempo a determinar (i) si se encuadran dentro de uno de los operadores obligados por el Reglamento, (ii) si desarrollan o utilizan algún tipo de sistema o modelo de IA y, en caso afirmativo, (iii) clasificar su nivel de riesgo conforme a la ley y, por último, (iv) determinar el impacto y las consecuencias de la aplicación del Reglamento de IA en su organización.

Todo ello, sin perjuicio de la aplicación transversal de otras fuentes normativas en vigor que, como hemos indicado a lo largo del presente artículo, deben tenerse en consideración.

[1] Entendidos como aquellos sistemas basados en una máquina que está diseñado para funcionar con distintos niveles de autonomía y que puede mostrar capacidad de adaptación tras el despliegue, infiriendo de la información de entrada que recibe la manera de generar resultados de salida.

[2] Entendida como todo aquel modelo de IA con capacidad para crear contenido original como texto, imágenes, vídeo, audio o código de software en respuesta a una indicación o prompt formulado por el usuario. Los grandes modelos de IA generativa son un ejemplo típico de un modelo de IA de uso general, ya que permiten la generación flexible de contenidos que pueden adaptarse fácilmente a una amplia gama de tareas diferenciadas (Considerando 99 del RIA).

[3] Uso que, sin ir más lejos, puede tener lugar al adjuntar documentos no anonimizados a un sistema de IA para que los analice y genere un determinado output atendiendo a su contenido.

[4] Finalmente se descartó la imposición de sanción pecuniaria, a pesar de las reiteradas alucinaciones del sistema de IA -que citó jurisprudencia inexistente y legislación de países como Colombia-, atendiendo a la inmediata reacción del Letrado excusando el error cometido.